OpenAI ha lanciato GPT-4o, una nuova versione del famoso modello che alimenta il suo principale prodotto, ChatGPT.

Durante un annuncio in diretta ieri, Mira Murati, CTO dell'azienda, ha evidenziato che il modello aggiornato è "notevolmente più rapido" e ha spiegato come la "o" del nome stia per "omni", indicando i progressi nel campo multimodale e le migliorate "abilità nel trattare testi, video e audio".

OpenAI ha annunciato che le funzioni di GPT-4o "saranno distribuite in modo iterativo", ma le sue capacità di testo e immagine saranno disponibili da subito in ChatGPT e saranno accessibili gratuitamente a tutti gli utenti, con quelli a pagamento che godranno di "fino a cinque volte le capacità degli utenti gratuiti".

Caratterizzato da una maggiore reattività e dalla capacità di gestire immagini, lingue straniere e riconoscimento emotivo, GPT-4o è pensato per interazioni uomo-macchina più fluide e personalizzate, mentre "memorizza" le conversazioni passate.

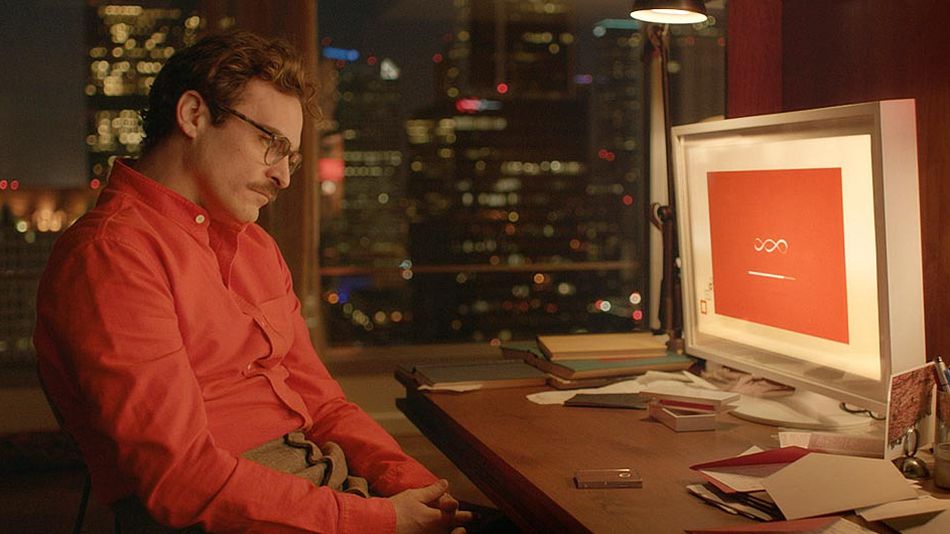

Scarlett, sei tu?

Sam Altman, CEO di OpenAI, ha descritto GPT-4o come "nativamente multimodale".

Questo nuovo modello ha una maggiore capacità di generare contenuti o comprendere comandi attraverso voce, testo o immagini, portando soprattutto nuove funzionalità alla modalità vocale di ChatGPT.

Ora il chatbot può agire come assistente vocale rispondendo in tempo reale e osservando l'ambiente circostante: capacità che evocano immediatamente un richiamo al film "Her" in cui Scarlett Johansson presta la voce ad una IA dai simili tratti.

In passato, la modalità vocale del modello era limitata, capace di rispondere a un singolo prompt per volta e operando solo in base a ciò che gli era concesso udire; richiedeva una latenza media di 2,8 secondi (GPT-3.5) o 5,4 secondi (GPT-4), dovuta alla necessità di utilizzare modelli separati per la trascrizione audio e la sintesi vocale.

GPT-4o integra tali processi, consentendo una gestione più efficiente degli input e degli output: presenta un ritardo di soli 232 millisecondi tra domanda e risposta, cosa che lo avvicina notevolmente ai tempi umani.

Durante una dimostrazione dal vivo, GPT-4o ha inoltre mostrato la sua capacità di fornire suggerimenti su problemi matematici, analizzare codice informatico e interpretare emozioni dalle espressioni facciali.

Nonostante piccoli inconvenienti, come interpretazioni errate di immagini e iniziative non richieste, il potenziale di GPT-4o si è dimostrato fortemente all'avanguardia.

In termini di sicurezza, OpenAI ha integrato misure preventive nel suo design, inclusi il filtraggio dei dati di addestramento e il miglioramento del comportamento del modello tramite la post-formazione.

Inoltre, la società ha collaborato con esperti esterni per identificare e mitigare i rischi associati alle nuove funzionalità, come l'output vocale.

Delega per un mondo migliore

Prima del lancio di ieri, c'erano rapporti contrastanti sulle aspettative riguardo a ciò che OpenAI avrebbe annunciato: un motore di ricerca AI per competere con Google, l'integrazione di Perplexity o addirittura un nuovo e migliorato modello, GPT-5.

OpenAI ha comunque operato strategicamente rilasciando queste novità poco prima del Google I/O, la conferenza principale del gigante di Mountain View, che vede il lancio di vari prodotti AI dal team Gemini e prevista per oggi alle 19.

In un post sul blog dopo l'evento in diretta, Altman ha riflettuto sul percorso di OpenAI, riconoscendo un cambiamento nella visione dell'azienda. Sebbene l'obiettivo iniziale fosse quello di "creare tutti i tipi di benefici per il mondo", Altman ha indicato che la focalizzazione è ora sul rendere i modelli AI avanzati disponibili agli sviluppatori tramite API a pagamento, consentendo a terze parti di "utilizzarli per creare tutti i tipi di cose incredibili di cui tutti beneficeremo."

Le funzionalità di GPT-4o saranno implementate direttamente in ChatGPT, con una modalità vocale in versione alpha che sarà presto disponibile per gli abbonati ChatGPT Plus.

Altman ha aggiunto su X che gli sviluppatori interessati a sperimentare con GPT-4o avranno accesso all'API, caratterizzata da un prezzo ridotto del 50% e da una velocità doppia rispetto a GPT-4 Turbo.

Oltre a GPT-4o, OpenAI ha annunciato miglioramenti all'interfaccia web di ChatGPT e il lancio di un'app desktop per Mac, con una versione per Windows prevista per la fine dell'anno.

Inoltre, alcune funzionalità precedentemente riservate agli abbonati premium saranno ora disponibili gratuitamente, inclusa l'opportunità di accedere al GPT Store per creare e condividere chatbot personalizzati.